京公网安备 11010802034615号

经营许可证编号:京B2-20210330

京公网安备 11010802034615号

经营许可证编号:京B2-20210330

拥抱大数据需要大智慧

近年来,有关大数据的热点话题一浪高过一浪,关注大数据应用的人也越来越多。总体来说,人们对大数据的前景持乐观态度,比如谈到大数据的技术特征,人们最容易想起的就是4个“v”:vast(数量庞大)、variety(种类繁多)、velocity(增长迅速)和value(总价值高)。这些都没错,但仔细一想,它们都是偏重说明大数据的正面优势的。但其实,大也有大的难处,大数据也不可避免地存在着一些负面劣势。结合笔者的从业经验,大数据的负面劣势可以概括为4个“n”,下面逐一说明每个n的含义。

inflated大数据是肥胖的。大数据的大不仅仅体现在数据记录的行数多,更体现在字段变量的列数多,这就为分析多因素之间的关联性带来了难度。哪怕是最简单的方差分析,计算一两个还行,计算一两百个就让人望而生畏了。

unstructured大数据是非结构化的。大数据的结构也是非常复杂的,既包括像交易额、时间等连续型变量,像性别、工作类型等离散型变量这样传统的结构化数据,更增添了如文本、社会关系网络,乃至语音、图像等大量新兴的非结构化数据,而这些非结构化数据蕴含的信息量往往更加巨大,但分析手段却略显单薄。

incomplete大数据是残缺的。在现实的世界里,由于用户登记的信息不全、计算机数据存储的错误等种种原因,数据缺失是常见的现象。在大数据的场景下,数据缺失更是家常便饭,这就为后期的分析与建模质量增加了不确定的风险。

abnormal大数据是异常的。同样,在现实的世界里,大数据里还有不少异常值(outlier)。比如某些连续型变量(如一个短期时间内的交易金额)的取之太大,某些离散型变量(如某个被选购的产品名称)里的某个水平值出现的次数太少,等等。如果不删除,很可能干扰模型系数的计算和评估;如果直接删除,又觉得缺乏说服力,容易引起他人的质疑。这使得分析人员落到了一个进退两难的境地。

如果不能处理好这些不利因素,大数据应用的优势很难发挥出来。想要拥抱大数据,并不是一项在常规条件下数据分析的简单升级,而是一项需要大智慧的综合工作。STIR(唤醒)策略是笔者在实践工作中提炼出来的、能够在实际工作中有效克服大数据负面劣势的应对方法。具体来说,STIR策略包含了四种技术手段,目前都已经有机地整合在统计分析与数据挖掘专业软件JMP中了,它可以用来解决上文提出的四个问题,下面将分别说明。

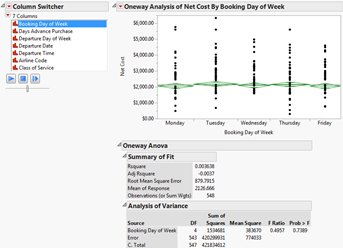

Switching Variables切换变量

它是用来解决大数据“残缺”问题的。通过“列转换器”、“动画播放”等工具,海量因素之间的关联性分析变得十分简单、快捷,还可以根据需要对关联性的重要程度进行排序,大数据分析的效率由此得到大幅提升。

基于JMP软件的关联性分析筛选的界面

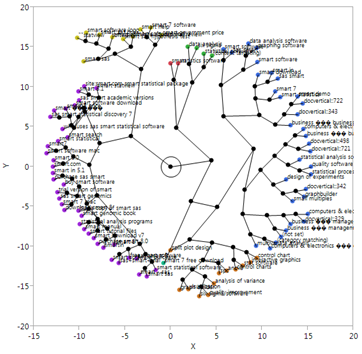

Text Mining文本挖掘

它是用来解决大数据“非结构化”问题的。通过先对文字、图像等新媒体信息源进行降维、去噪、转换等处理,产生结构化数据,再用成熟的统计分析和数据挖掘方法进行评价和解释。这样一来,大数据的应用范围得到了极大的拓展。

基于JMP软件的文本分析结果的最终展现界面

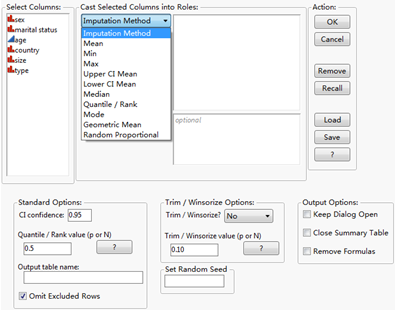

Imputation缺失数赋值

它是用来解决大数据“残缺”问题的。在有missing data的时候,我们并不完全排斥直接删除的方法,但更多的时候,我们会在条件允许的情况下,用赋值的方法去替代原先的缺失值。具体的技术很多,简单的如计算平均值、中位数、众数之类的统计量,复杂的如用回归、决策树、贝叶斯定理去预测缺失数的近似值等。这样一来,大数据的质量大为改观,为后期的分析与建模奠定了扎实的基础。

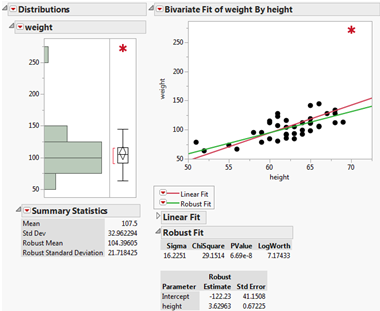

Robust Modeling稳健建模

它是用来解决大数据“异常”问题的。在融入了自动识别、重要性加权等处理手段后,分析人员既直接消除了个别强影响点的敏感程度,又综合考虑了所有数据的影响,增强了模型的抗干扰能力,使得模型体现出良好的预测特性,由此做出的业务决策自然变得更加科学、精准。

总之,我们必须要对大数据有一个全面、客观的认识。只有在不同的业务和数据背景下采用不同的战略战术,才能在大数据时代,真正发挥大数据的杠杆作用,有效提高企业的运营效率和市场竞争力。

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

箱线图(Box Plot)作为数据分布可视化的核心工具,能清晰呈现数据的中位数、四分位数、异常值等关键统计特征,广泛应用于数据分 ...

2026-01-28在回归分析、机器学习建模等数据分析场景中,多重共线性是高频数据问题——当多个自变量间存在较强的线性关联时,会导致模型系数 ...

2026-01-28数据分析的价值落地,离不开科学方法的支撑。六种核心分析方法——描述性分析、诊断性分析、预测性分析、规范性分析、对比分析、 ...

2026-01-28在机器学习与数据分析领域,特征是连接数据与模型的核心载体,而特征重要性分析则是挖掘数据价值、优化模型性能、赋能业务决策的 ...

2026-01-27关联分析是数据挖掘领域中挖掘数据间潜在关联关系的经典方法,广泛应用于零售购物篮分析、电商推荐、用户行为路径挖掘等场景。而 ...

2026-01-27数据分析的基础范式,是支撑数据工作从“零散操作”走向“标准化落地”的核心方法论框架,它定义了数据分析的核心逻辑、流程与目 ...

2026-01-27在数据分析、后端开发、业务运维等工作中,SQL语句是操作数据库的核心工具。面对复杂的表结构、多表关联逻辑及灵活的查询需求, ...

2026-01-26支持向量机(SVM)作为机器学习中经典的分类算法,凭借其在小样本、高维数据场景下的优异泛化能力,被广泛应用于图像识别、文本 ...

2026-01-26在数字化浪潮下,数据分析已成为企业决策的核心支撑,而CDA数据分析师作为标准化、专业化的数据人才代表,正逐步成为连接数据资 ...

2026-01-26数据分析的核心价值在于用数据驱动决策,而指标作为数据的“载体”,其选取的合理性直接决定分析结果的有效性。选对指标能精准定 ...

2026-01-23在MySQL查询编写中,我们习惯按“SELECT → FROM → WHERE → ORDER BY”的语法顺序组织语句,直觉上认为代码顺序即执行顺序。但 ...

2026-01-23数字化转型已从企业“可选项”升级为“必答题”,其核心本质是通过数据驱动业务重构、流程优化与模式创新,实现从传统运营向智能 ...

2026-01-23CDA持证人已遍布在世界范围各行各业,包括世界500强企业、顶尖科技独角兽、大型金融机构、国企事业单位、国家行政机关等等,“CDA数据分析师”人才队伍遵守着CDA职业道德准则,发挥着专业技能,已成为支撑科技发展的核心力量。 ...

2026-01-22在数字化时代,企业积累的海量数据如同散落的珍珠,而数据模型就是串联这些珍珠的线——它并非简单的数据集合,而是对现实业务场 ...

2026-01-22在数字化运营场景中,用户每一次点击、浏览、交互都构成了行为轨迹,这些轨迹交织成海量的用户行为路径。但并非所有路径都具备业 ...

2026-01-22在数字化时代,企业数据资产的价值持续攀升,数据安全已从“合规底线”升级为“生存红线”。企业数据安全管理方法论以“战略引领 ...

2026-01-22在SQL数据分析与业务查询中,日期数据是高频处理对象——订单创建时间、用户注册日期、数据统计周期等场景,都需对日期进行格式 ...

2026-01-21在实际业务数据分析中,单一数据表往往无法满足需求——用户信息存储在用户表、消费记录在订单表、商品详情在商品表,想要挖掘“ ...

2026-01-21在数字化转型浪潮中,企业数据已从“辅助资源”升级为“核心资产”,而高效的数据管理则是释放数据价值的前提。企业数据管理方法 ...

2026-01-21在数字化商业环境中,数据已成为企业优化运营、抢占市场、规避风险的核心资产。但商业数据分析绝非“堆砌数据、生成报表”的简单 ...

2026-01-20