京公网安备 11010802034615号

经营许可证编号:京B2-20210330

京公网安备 11010802034615号

经营许可证编号:京B2-20210330

在2011年、2012年大数据概念火了之后,可以说这几年许多传统企业也好,互联网企业也好,都把自己的业务给大数据靠一靠,并且提的比较多的大数据思维。

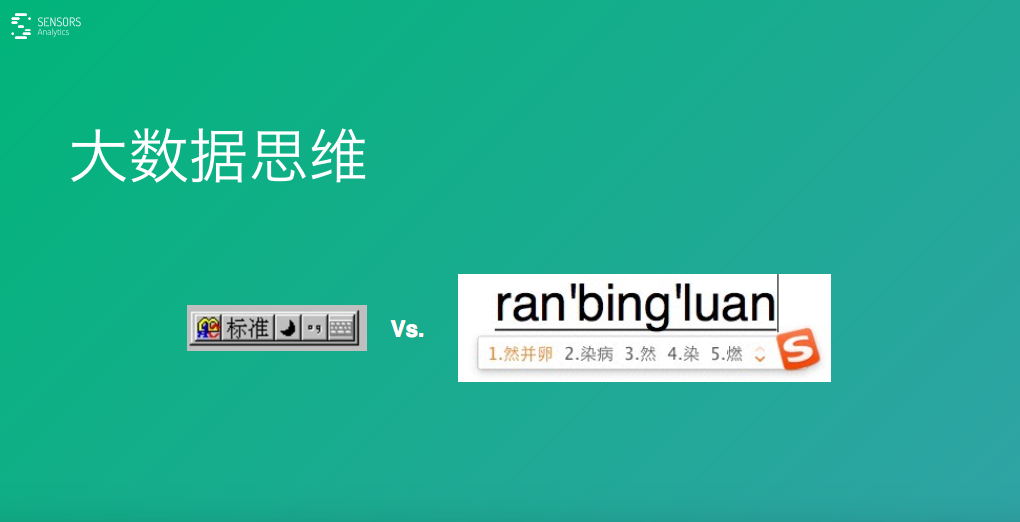

那么大数据思维是怎么回事?我们来看两个例子:

首先,我们来看一下输入法的例子。

我2001年上大学,那时用的输入法比较多的是智能ABC,还有微软拼音,还有五笔。那时候的输入法比现在来说要慢的很多,许多时候输一个词都要选好几次,去选词还是调整才能把这个字打出来,效率是非常低的。

到了2002年,2003年出了一种新的输出法——紫光拼音,感觉真的很快,键盘没有按下去字就已经跳出来了。但是,后来很快发现紫光拼音输入法也有它的问题,比如当时互联网发展已经比较快了,会经常出现一些新的词汇,这些词汇在它的词库里没有的话,就很难敲出来这个词。

在2006年左右,搜狗输入法出现了。搜狗输入法基于搜狗本身是一个搜索,它积累了一些用户输入的检索词这些数据,用户用输入法时候产生的这些词的信息,将它们进行统计分析,把一些新的词汇逐步添加到词库里去,通过云的方式进行管理。

比 如,去年流行一个词叫“然并卵”,这样的一个词如果用传统的方式,因为它是一个重新构造的词,在输入法是没办法通过拼音“ran bing luan”直接把它找出来的。然而,在大数据思维下那就不一样了,换句话说,我们先不知道有这么一个词汇,但是我们发现有许多人在输入了这个词汇,于是, 我们可以通过统计发现最近新出现的一个高频词汇,把它加到司库里面并更新给所有人,大家在使用的时候可以直接找到这个词了。

再 来看一个地图的案例,在这种电脑地图、手机地图出现之前,我们都是用纸质的地图。这种地图差不多就是一年要换一版,因为许多地址可能变了,并且在纸质地图 上肯定是看不出来,从一个地方到另外一个地方怎么走是最好的?中间是不是堵车?这些都是有需要有经验的各种司机才能判断出来。

在有了百度地图这样的产品就要好很多,比如:它能告诉你这条路当前是不是堵的?或者说能告诉你半个小时之后它是不是堵的?它是不是可以预测路况情况?

此 外,你去一个地方它可以给你规划另一条路线,这些就是因为它采集到许多数据。比如:大家在用百度地图的时候,有GPS地位信息,基于你这个位置的移动信 息,就可以知道路的拥堵情况。另外,他可以收集到很多用户使用的情况,可以跟交管局或者其他部门来采集一些其他摄像头、地面的传感器采集的车辆的数量的数 据,就可以做这样的判断了。

这里,我们来看一看纸质的地图跟新的手机地图之间,智能ABC输入法跟搜狗输入法都有什么区别?

这 里面最大的差异就是有没有用上新的数据。这里就引来了一个概念——数据驱动。有了这些数据,基于数据上统计也好,做其他挖掘也好,把一个产品做的更加智 能,变得更加好,这个跟它对应的就是之前可能没有数据的情况,可能是拍脑袋的方式,或者说我们用过去的,我们想清楚为什么然后再去做这个事情。这些相比之 下数据驱动这种方式效率就要高很多,并且有许多以前解决不了的问题它就能解决的非常好。

对于数据驱动这一点,可能有些人从没有看数的习惯到了看数的习惯那是一大进步,是不是能看几个数这就叫数据驱动了呢?这还远远不够,这里来说一下什么是数据驱动?或者现有的创业公司在进行数据驱动这件事情上存在的一些问题。

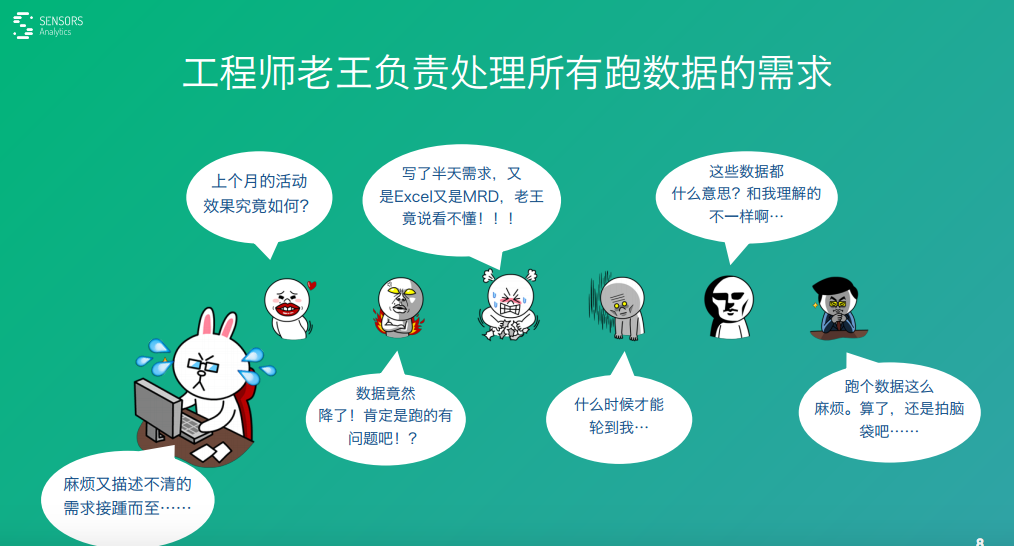

一种情况大家在公司里面有一个数据工程师,他的工作职责就是跑数据。

不 管是市场也好,产品也好,运营也好,老板也好,大家都会有各种各样的数据需求,但都会提给他。然而,这个资源也是有限的,他的工作时间也是有限的,只能一 个一个需求去处理,他本身工作很忙,大家提的需求之后可能并不会马上就处理,可能需要等待一段时间。即使处理了这个需求,一方面他可能数据准备的不全,他 需要去采集一些数据,或做一些升级,他要把数据拿过来。拿过来之后又在这个数据上进行一些分析,这个过程本身可能两三天时间就过去了,如果加上等待的时间 更长。

对于有些人来说,这个等待周期太长,整个时机可能就错过了。比如,你重要的就 是考察一个节日或者一个开学这样一个时间点,然后想搞一些运营相关的事情,这个时机可能就错过去了,许多人等不到了,有些同学可能就干脆还是拍脑袋,就不 等待这个数据了。这个过程其实就是说效率是非常低的,并不是说拿不到这个数据,而是说效率低的情况下我们错过了很多机会。

对于还有一些公司来说,之前可能连个数都没有,现在有了一个仪表盘,有了仪表盘可以看到公司上个季度、昨天总体的这些数据,还是很不错的。

对老板来说肯定还是比较高兴,但是,对于市场、运营这些同学来说可能就还不够。

比 如,我们发现某一天的用户量跌了20%,这个时候肯定不能放着不管,需要查一查这个问题出在哪。这个时候,只看一个宏观的数那是远远不够的,我们一般要对 这个数据进行切分,按地域、按渠道,按不同的方式去追查,看到底是哪少了,是整体少了,还是某一个特殊的渠道独特的地方它这个数据少了,这个时候单单靠一 个仪表盘是不够的。

理想状态的数据驱动应该是怎么样的?就是一个自助式的数据分析,让业务人员每一个人都能自己去进行数据分析,掌握这个数据。

前 面我讲到一个模式,我们源头是一堆杂乱的数据,中间有一个工程师用来跑这个数据,然后右边是接各种业务同学提了需求,然后排队等待被处理,这种方式效率是 非常低的。理想状态来说,我们现象大数据源本身整好,整全整细了,中间提供强大的分析工具,让每一个业务员都能直接进行操作,大家并发的去做一些业务上的 数据需求,这个效率就要高非常多。

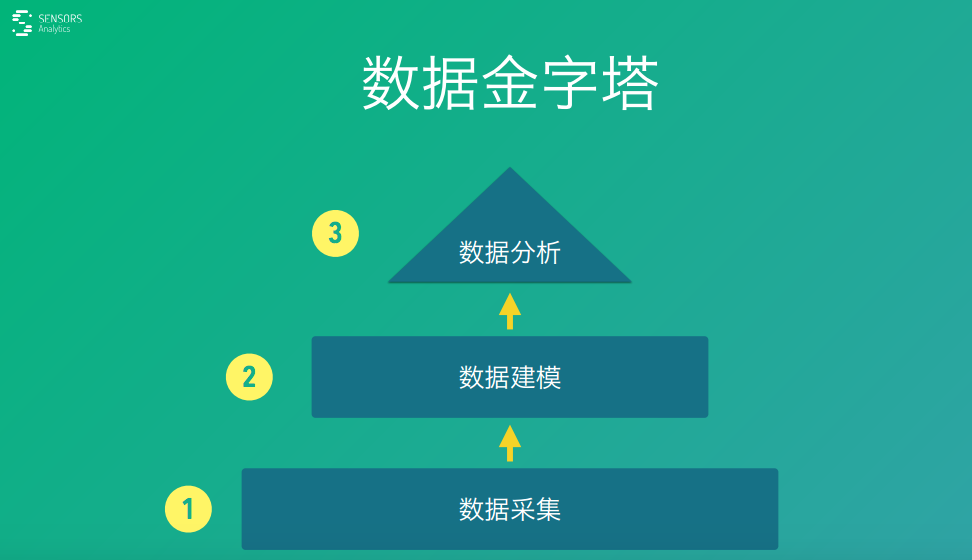

大数据分析这件事用一种非技术的角度来看的话,就可以分成金字塔,自底向上的是三个部分,第一个部分是数据采集,第二个部分是数据建模,第三个部分是数据分析,我们来分别看一下。

首先来说一下数据采集,我在百度干了有七年是数据相关的事情。我最大的心得——数据这个事情如果想要更好,最重要的就是数据源,数据源这个整好了之后,后面的事情都很轻松。

用一个好的查询引擎、一个慢的查询引擎无非是时间上可能消耗不大一样,但是数据源如果是差的话,后面用再复杂的算法可能都解决不了这个问题,可能都是很难得到正确的结论。

我觉得好的数据处理流程有两个基本的原则,一个是全,一个是细。

全:

就 是说我们要拿多种数据源,不能说只拿一个客户端的数据源,服务端的数据源没有拿,数据库的数据源没有拿,做分析的时候没有这些数据你可能是搞歪了。另外, 大数据里面讲的是全量,而不是抽样。不能说只抽了某些省的数据,然后就开始说全国是怎么样。可能有些省非常特殊,比如新疆、西藏这些地方客户端跟内地可能 有很大差异的。

细:

其 实就是强调多维度,在采集数据的时候尽量把每一个的维度、属性、字段都给它采集过来。比如:像where、who、how这些东西给它替补下来,后面分析 的时候就跳不出这些能够所选的这个维度,而不是说开始的时候也围着需求。根据这个需求确定了产生某些数据,到了后面真正有一个新的需求来的时候,又要采集 新的数据,这个时候整个迭代周期就会慢很多,效率就会差很多,尽量从源头抓的数据去做好采集。

有了数据之后,就要对数据进行加工,不能把原始的数据直接报告给上面的业务分析人员,它可能本身是杂乱的,没有经过很好的逻辑的。

这里就牵扯到数据建框,首先,提一个概念就是数据模型。许多人可能对数据模型这个词产生一种畏惧感,觉得模型这个东西是什么高深的东西,很复杂,但其实这个事情非常简单。

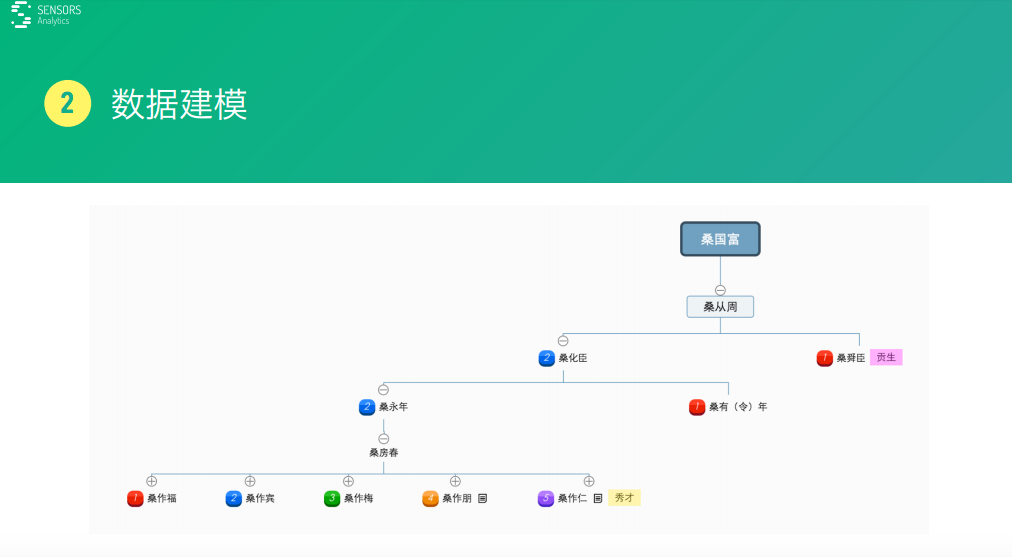

我春节期间在家干过一件事情,我自己家里面家谱在文革的时候被烧了,后来家里的长辈说一定要把家谱这些东西给存档一下,因为我会电脑,就帮着用电脑去理了一下这些家族的数据这些关系,整个族谱这个信息。

我们现实是一个个的人,家谱里面的人,通过一个树型的结构,还有它们之间数据关系,就能把现实实体的东西用几个简单图给表示出来,这里就是一个数据模型。

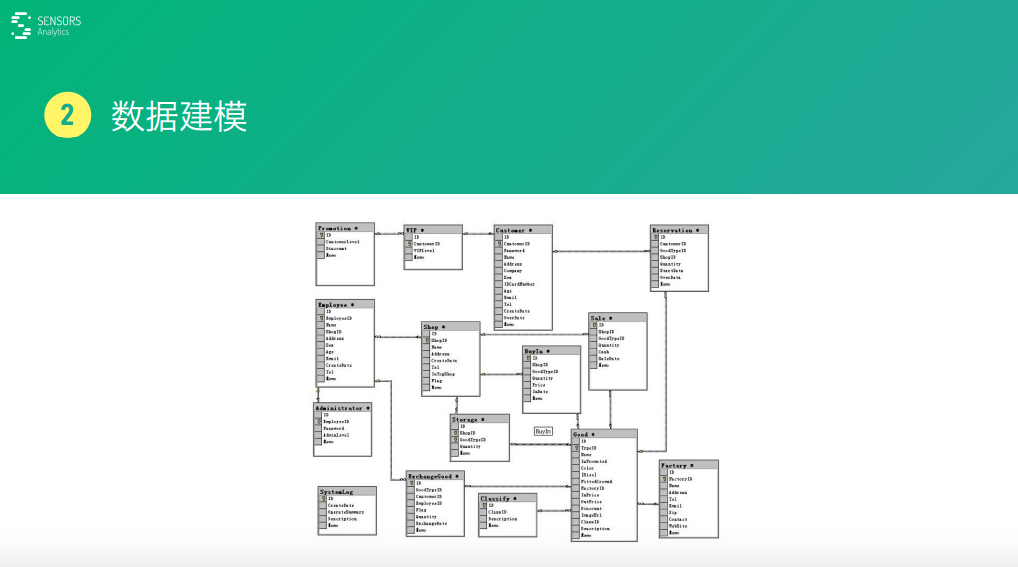

数据模型就是对现实世界的一个抽象化的数据的表示。我们这些创业公司经常是这么一个情况,我们现在这种业务,一般前端做一个请求,然后对请求经过处理,再更新到数据库里面去,数据库里面建了一系列的数据表,数据表之间都是很多的依赖关系。

比如,就像我图片里面展示的这样,这些表一个业务项发展差不多一年以上它可能就牵扯到几十张甚至上百张数据表,然后把这个表直接提供给业务分析人员去使用,理解起来难度是非常大的。

这个数据模型是用于满足你正常的业务运转,为产品正常的运行而建的一个数据模型。但是,它并不是一个针对分析人员使用的模型。如果,非要把它用于数据分析那就带来了很多问题。比如:它理解起来非常麻烦。

另外,数据分析很依赖表之间的这种格子,比如:某一天我们为了提升性能,对某一表进行了拆分,或者加了字段、删了某个字短,这个调整都会影响到你分析的逻辑。

这里,最好要针对分析的需求对数据重新进行解码,它内容可能是一致的,但是我们的组织方式改变了一下。就拿用户行为这块数据来说,就可以对它进行一个抽象,然后重新把它作为一个判断表。

用 户在产品上进行的一系列的操作,比如浏览一个商品,然后谁浏览的,什么时间浏览的,他用的什么操作系统,用的什么浏览器版本,还有他这个操作看了什么商 品,这个商品的一些属性是什么,这个东西都给它进行了一个很好的抽象。这种抽样的很大的好处很容易理解,看过去一眼就知道这表是什么,对分析来说也更加方 便。

在数据分析方,特别是针对用户行为分析方面,目前比较有效的一个模型就是多维数据模型,在线分析处理这个模型,它里面有这个关键的概念,一个是维度,一个是指标。

维度比如城市,然后北京、上海这些一个维度,维度西面一些属性,然后操作系统,还有IOS、安卓这些就是一些维度,然后维度里面的属性。

通过维度交叉,就可以看一些指标问题,比如用户量、销售额,这些就是指标。比如,通过这个模型就可以看来自北京,使用IOS的,他们的整体销售额是怎么样的。

这里只是举了两个维度,可能还有很多个维度。总之,通过维度组合就可以看一些指标的数,大家可以回忆一下,大家常用的这些业务的数据分析需求是不是许多都能通过这种简单的模式给抽样出来。

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

在数据分析、业务决策、科学研究等领域,统计模型是连接原始数据与业务价值的核心工具——它通过对数据的规律提炼、变量关联分析 ...

2026-02-14在SQL查询实操中,SELECT * 与 SELECT 字段1, 字段2,...(指定个别字段)是最常用的两种查询方式。很多开发者在日常开发中,为了 ...

2026-02-14对CDA(Certified Data Analyst)数据分析师而言,数据分析的核心不是孤立解读单个指标数值,而是构建一套科学、完整、贴合业务 ...

2026-02-14在Power BI实操中,函数是实现数据清洗、建模计算、可视化呈现的核心工具——无论是简单的数据筛选、异常值处理,还是复杂的度量 ...

2026-02-13在互联网运营、产品迭代、用户增长等工作中,“留存率”是衡量产品核心价值、用户粘性的核心指标——而次日留存率,作为留存率体 ...

2026-02-13对CDA(Certified Data Analyst)数据分析师而言,指标是贯穿工作全流程的核心载体,更是连接原始数据与业务洞察的关键桥梁。CDA ...

2026-02-13在机器学习建模实操中,“特征选择”是提升模型性能、简化模型复杂度、解读数据逻辑的核心步骤——而随机森林(Random Forest) ...

2026-02-12在MySQL数据查询实操中,按日期分组统计是高频需求——比如统计每日用户登录量、每日订单量、每日销售额,需要按日期分组展示, ...

2026-02-12对CDA(Certified Data Analyst)数据分析师而言,描述性统计是贯穿实操全流程的核心基础,更是从“原始数据”到“初步洞察”的 ...

2026-02-12备考CDA的小伙伴,专属宠粉福利来啦! 不用拼运气抽奖,不用复杂操作,只要转发CDA真题海报到朋友圈集赞,就能免费抱走实用好礼 ...

2026-02-11在数据科学、机器学习实操中,Anaconda是必备工具——它集成了Python解释器、conda包管理器,能快速搭建独立的虚拟环境,便捷安 ...

2026-02-11在Tableau数据可视化实操中,多表连接是高频操作——无论是将“产品表”与“销量表”连接分析产品销量,还是将“用户表”与“消 ...

2026-02-11在CDA(Certified Data Analyst)数据分析师的实操体系中,统计基本概念是不可或缺的核心根基,更是连接原始数据与业务洞察的关 ...

2026-02-11在数字经济飞速发展的今天,数据已成为核心生产要素,渗透到企业运营、民生服务、科技研发等各个领域。从个人手机里的浏览记录、 ...

2026-02-10在数据分析、实验研究中,我们经常会遇到小样本配对数据的差异检验场景——比如同一组受试者用药前后的指标对比、配对分组的两组 ...

2026-02-10在结构化数据分析领域,透视分析(Pivot Analysis)是CDA(Certified Data Analyst)数据分析师最常用、最高效的核心实操方法之 ...

2026-02-10在SQL数据库实操中,字段类型的合理设置是保证数据运算、统计准确性的基础。日常开发或数据分析时,我们常会遇到这样的问题:数 ...

2026-02-09在日常办公数据分析中,Excel数据透视表是最常用的高效工具之一——它能快速对海量数据进行分类汇总、分组统计,将杂乱无章的数 ...

2026-02-09表结构数据作为结构化数据的核心载体,其“获取-加工-使用”全流程,是CDA(Certified Data Analyst)数据分析师开展专业工作的 ...

2026-02-09在互联网产品运营、用户增长的实战场景中,很多从业者都会陷入一个误区:盲目投入资源做推广、拉新,却忽视了“拉新后的用户激活 ...

2026-02-06