京公网安备 11010802034615号

经营许可证编号:京B2-20210330

京公网安备 11010802034615号

经营许可证编号:京B2-20210330

说明

随机森林是另一类可用的集成学习方法,该算法在训练过程中将产生多棵决策树,每棵决策树会根据输入数据集产生相应的预测输出,算法采用投票机制选择类别众数做为预测结果。

操作

导入随机森林包:

library(randomForest)

使用随机森林分类器处理训练数据:

churn.rf = randomForest(churn ~ .,data = trainset,importance = T)

churn.rf

Call:

randomForest(formula = churn ~ ., data = trainset, importance = T)

Type of random forest: classification

Number of trees: 500

No. of variables tried at each split: 4

OOB estimate of error rate: 5.27%

Confusion matrix:

yes no class.error

yes 245 97 0.28362573

no 25 1948 0.01267106

利用训练好的模型对测试集进行分类预测:

churn.prediction = predict(churn.rf,testset)

类似其它分类处理,产生分类表:

table(churn.prediction,testset$churn)

churn.prediction yes no

yes 111 7

no 30 870

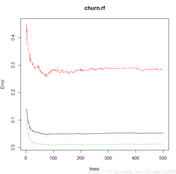

调用plot函数绘制森林对象均方差:

plot(churn.rf)

随机森林的均方差

根据建立好的模型评估各属性的重要度:

importance(churn.rf)

yes no MeanDecreaseAccuracy MeanDecreaseGini

international_plan 68.9592890 54.118994 72.190204 50.35584

voice_mail_plan 18.8899994 15.832400 19.607844 10.44601

number_vmail_messages 21.3080062 16.262770 22.068514 19.05619

total_day_minutes 28.3237379 30.323756 39.961077 79.91474

total_day_calls 0.6325725 -1.131930 -0.802642 20.80946

total_day_charge 28.4798708 28.146414 35.858906 77.84837

total_eve_minutes 18.5242988 20.572464 24.484322 42.99373

total_eve_calls -3.3431379 -2.301767 -3.495801 17.45619

total_eve_charge 20.4379809 20.619705 24.489771 44.02855

total_night_minutes 0.9451961 16.105720 16.694651 22.93663

total_night_calls -0.3497164 2.202619 1.869193 19.94091

total_night_charge 0.1110824 15.977083 16.593633 22.22769

total_intl_minutes 17.3951655 20.063485 24.967698 26.05059

total_intl_calls 37.3613313 23.415764 35.497785 33.03289

total_intl_charge 16.7925666 19.636891 24.498369 26.60077

number_customer_service_calls 79.7530696 59.731615 85.221845 67.29635

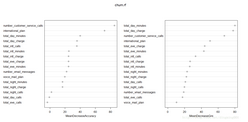

调用varlmPlot函数绘制变量重要性曲线

varImpPlot(churn.rf)

变量重要性示例

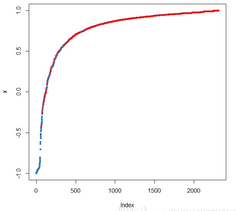

调用margin及plot函数并绘制边缘累计分布图:

margins.rf = margin(churn.rf,trainset)

plot(margins.rf)

随机森林算法边缘累积分布图

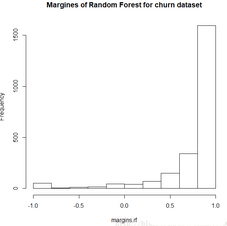

还可以用直方图来绘制随机森林的边缘分布:

hist(margins.rf,main = "Margines of Random Forest for churn dataset")

边缘分布直方图

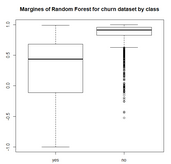

调用boxplot绘制随机森林各类别边缘的箱线图

boxplot(margins.rf ~ trainset$churn,main = "Margines of Random Forest for churn dataset by class")

随机森林类别边缘箱图

原理:

随机森林算法目标是通过将多个弱学习机(如单棵决策树)组合得到一个强学习机,算法的处理过程与bagging方法非常相似,假设当拥有N个特征数为M的样例,首先采用bootstrap对数据集进行采样,每次随机采样N个样本作为单个决策树的训练数据集。在每个节点,算法首先随机选取m(m << M)个变量,从它们中间找到能够提供最佳分割效果的预测属性。

然后,算法在不剪枝的前提下生成单颗决策树,最后从每个决策树都得到一个分类预测结果。

如果是回归分析,算法将取所有预测的平均值或者加权平均值作为最后刚出,如果是分类问题,则选择类别预测众数做为最终预测输出。

随机森林包括两个参数,ntree(决策树个数)和mtry(可用来寻找最佳特征的特征个数),而bagging算法只使用了一个ntree参数,因此,如果将mtry设置成与训练数据集特征值一样大时,随机森林算法就等同于bagging算法。

本例利用randomForest包提供的随机森林算法建立了分类模型,将importance值设置为“T”,以确保对预测器的重要性进行评估。

与bagging和boosting方法类似,一旦随机森林的模型构建完成,我们就能利用其对测试数据集进行预测,并得到相应的分类表。

randomForest包还提供了importance和varlmpPlot函数则可以通过绘制平均精确度下降或者平均基尼下降曲线实现属性重要性的可视化。

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

B+树作为数据库索引的核心数据结构,其高效的查询、插入、删除性能,离不开节点间指针的合理设计。在日常学习和数据库开发中,很 ...

2026-01-30在数据库开发中,UUID(通用唯一识别码)是生成唯一主键、唯一标识的常用方式,其标准格式包含4个短横线(如550e8400-e29b-41d4- ...

2026-01-30商业数据分析的价值落地,离不开标准化、系统化的总体流程作为支撑;而CDA(Certified Data Analyst)数据分析师,作为经过系统 ...

2026-01-30在数据分析、质量控制、科研实验等场景中,数据波动性(离散程度)的精准衡量是判断数据可靠性、稳定性的核心环节。标准差(Stan ...

2026-01-29在数据分析、质量检测、科研实验等领域,判断数据间是否存在本质差异是核心需求,而t检验、F检验是实现这一目标的经典统计方法。 ...

2026-01-29统计制图(数据可视化)是数据分析的核心呈现载体,它将抽象的数据转化为直观的图表、图形,让数据规律、业务差异与潜在问题一目 ...

2026-01-29箱线图(Box Plot)作为数据分布可视化的核心工具,能清晰呈现数据的中位数、四分位数、异常值等关键统计特征,广泛应用于数据分 ...

2026-01-28在回归分析、机器学习建模等数据分析场景中,多重共线性是高频数据问题——当多个自变量间存在较强的线性关联时,会导致模型系数 ...

2026-01-28数据分析的价值落地,离不开科学方法的支撑。六种核心分析方法——描述性分析、诊断性分析、预测性分析、规范性分析、对比分析、 ...

2026-01-28在机器学习与数据分析领域,特征是连接数据与模型的核心载体,而特征重要性分析则是挖掘数据价值、优化模型性能、赋能业务决策的 ...

2026-01-27关联分析是数据挖掘领域中挖掘数据间潜在关联关系的经典方法,广泛应用于零售购物篮分析、电商推荐、用户行为路径挖掘等场景。而 ...

2026-01-27数据分析的基础范式,是支撑数据工作从“零散操作”走向“标准化落地”的核心方法论框架,它定义了数据分析的核心逻辑、流程与目 ...

2026-01-27在数据分析、后端开发、业务运维等工作中,SQL语句是操作数据库的核心工具。面对复杂的表结构、多表关联逻辑及灵活的查询需求, ...

2026-01-26支持向量机(SVM)作为机器学习中经典的分类算法,凭借其在小样本、高维数据场景下的优异泛化能力,被广泛应用于图像识别、文本 ...

2026-01-26在数字化浪潮下,数据分析已成为企业决策的核心支撑,而CDA数据分析师作为标准化、专业化的数据人才代表,正逐步成为连接数据资 ...

2026-01-26数据分析的核心价值在于用数据驱动决策,而指标作为数据的“载体”,其选取的合理性直接决定分析结果的有效性。选对指标能精准定 ...

2026-01-23在MySQL查询编写中,我们习惯按“SELECT → FROM → WHERE → ORDER BY”的语法顺序组织语句,直觉上认为代码顺序即执行顺序。但 ...

2026-01-23数字化转型已从企业“可选项”升级为“必答题”,其核心本质是通过数据驱动业务重构、流程优化与模式创新,实现从传统运营向智能 ...

2026-01-23CDA持证人已遍布在世界范围各行各业,包括世界500强企业、顶尖科技独角兽、大型金融机构、国企事业单位、国家行政机关等等,“CDA数据分析师”人才队伍遵守着CDA职业道德准则,发挥着专业技能,已成为支撑科技发展的核心力量。 ...

2026-01-22在数字化时代,企业积累的海量数据如同散落的珍珠,而数据模型就是串联这些珍珠的线——它并非简单的数据集合,而是对现实业务场 ...

2026-01-22