京公网安备 11010802034615号

经营许可证编号:京B2-20210330

京公网安备 11010802034615号

经营许可证编号:京B2-20210330

回归诊断主要内容

(1).误差项是否满足独立性,等方差性与正态

(2).选择线性模型是否合适

(3).是否存在异常样本

(4).回归分析是否对某个样本的依赖过重,也就是模型是否具有稳定性

(5).自变量之间是否存在高度相关,是否有多重共线性现象存在

通过了t检验与F检验,但是做为回归方程还是有问题

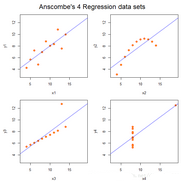

#举例说明,利用anscombe数据

## 调取数据集

data(anscombe)

## 分别调取四组数据做回归并输出回归系数等值

ff <- y ~ x

for(i in 1:4) {

ff[2:3] <- lapply(paste(c("y","x"), i, sep=""), as.name)

assign(paste("lm.",i,sep=""), lmi<-lm(ff, data=anscombe))

}

GetCoef<-function(n) summary(get(n))$coef

lapply(objects(pat="lm\\.[1-4]$"), GetCoef)

[[1]]

Estimate Std. Error t value Pr(>|t|)

(Intercept) 3.0000909 1.1247468 2.667348 0.025734051

x1 0.5000909 0.1179055 4.241455 0.002169629

[[2]]

Estimate Std. Error t value Pr(>|t|)

(Intercept) 3.000909 1.1253024 2.666758 0.025758941

x2 0.500000 0.1179637 4.238590 0.002178816

[[3]]

Estimate Std. Error t value Pr(>|t|)

(Intercept) 3.0024545 1.1244812 2.670080 0.025619109

x3 0.4997273 0.1178777 4.239372 0.002176305

[[4]]

Estimate Std. Error t value Pr(>|t|)

(Intercept) 3.0017273 1.1239211 2.670763 0.025590425

x4 0.4999091 0.1178189 4.243028 0.002164602

从计算结果可以知道,Estimate, Std. Error, t value, Pr(>|t|)这几个值完全不同,并且通过检验,进一步发现R^2,F值,p值完全相同,方差完全相同。事实上这四组数据完全不同,全部用线性回归不合适。

## 绘图

op <- par(mfrow=c(2,2), mar=.1+c(4,4,1,1), oma=c(0,0,2,0))

for(i in 1:4) {

ff[2:3] <- lapply(paste(c("y","x"), i, sep=""), as.name)

plot(ff, data =anscombe, col="red", pch=21,

bg="orange", cex=1.2, xlim=c(3,19), ylim=c(3,13))

abline(get(paste("lm.",i,sep="")), col="blue")

}

mtext("Anscombe's 4 Regression data sets",

outer = TRUE, cex=1.5)

par(op)

第1组数据适用于线性回归模型,第二组使用二次模型更加合理,第三组的一个点偏离于整体数据构成的回归直线,应该去掉。第四级做回归是不合理的,回归系只依赖一个点。在得到回归方程得到各种检验后,还要做相关的回归诊断。

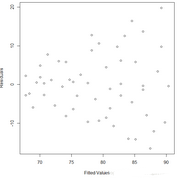

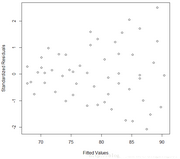

残差检验

残差的检验是检验模型的误差是否满足正态性和方差齐性,最简单直观的方法是画出残差图。观察残差分布情况,作出散点图。

#20-60岁血压与年龄分析

## (1) 回归

rt<-read.table("d:/R-TT/book1/1_R/chap06/blood.dat", header=TRUE)

lm.sol<-lm(Y~X, data=rt); lm.sol

summary(lm.sol)

Call:

lm(formula = Y ~ X, data = rt)

Residuals:

Min 1Q Median 3Q Max

-16.4786 -5.7877 -0.0784 5.6117 19.7813

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 56.15693 3.99367 14.061 < 2e-16 ***

X 0.58003 0.09695 5.983 2.05e-07 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 8.146 on 52 degrees of freedom

Multiple R-squared: 0.4077, Adjusted R-squared: 0.3963

F-statistic: 35.79 on 1 and 52 DF, p-value: 2.05e-07

## (2) 残差图

pre<-fitted.values(lm.sol)

#fitted value 配适值;拟合值

res<-residuals(lm.sol)

#计算回归模型的残差

rst<-rstandard(lm.sol)

#计算回归模型标准化残差

par(mai=c(0.9, 0.9, 0.2, 0.1))

plot(pre, res, xlab="Fitted Values", ylab="Residuals")

savePlot("resid-1", type="eps")

plot(pre, rst, xlab="Fitted Values",

ylab="Standardized Residuals")

savePlot("resid-2", type="eps")

残差

标准差

## (3) 对残差作回归,利用残差绝对值与自变量(x)作回归,其程序如下:

rt$res<-res

lm.res<-lm(abs(res)~X, data=rt); lm.res

summary(lm.res)

Call:

lm(formula = abs(res) ~ X, data = rt)

Residuals:

Min 1Q Median 3Q Max

-9.7639 -2.7882 -0.1587 3.0757 10.0350

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) -1.54948 2.18692 -0.709 0.48179

X 0.19817 0.05309 3.733 0.00047 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 4.461 on 52 degrees of freedom

Multiple R-squared: 0.2113, Adjusted R-squared: 0.1962

F-statistic: 13.93 on 1 and 52 DF, p-value: 0.0004705

si= -1.5495 + 0.1982x

## (4) 计算残差的标准差,利用方差(标准差的平方)的倒数作为样本点的权重,这样可以减少非齐性方差带来的影响

s<-lm.res$coefficients[1]+lm.res$coefficients[2]*rt$X

lm.weg<-lm(Y~X, data=rt, weights=1/s^2); lm.weg

summary(lm.weg)

Call:

lm(formula = Y ~ X, data = rt, weights = 1/s^2)

Weighted Residuals:

Min 1Q Median 3Q Max

-2.0230 -0.9939 -0.0327 0.9250 2.2008

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 55.56577 2.52092 22.042 < 2e-16 ***

X 0.59634 0.07924 7.526 7.19e-10 ***

---

Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 1.213 on 52 degrees of freedom

Multiple R-squared: 0.5214, Adjusted R-squared: 0.5122

F-statistic: 56.64 on 1 and 52 DF, p-value: 7.187e-10

修正后的回归方程:Y = 55.5658 + 0.5963x

数据分析咨询请扫描二维码

若不方便扫码,搜微信号:CDAshujufenxi

数据分析的核心价值在于用数据驱动决策,而指标作为数据的“载体”,其选取的合理性直接决定分析结果的有效性。选对指标能精准定 ...

2026-01-23在MySQL查询编写中,我们习惯按“SELECT → FROM → WHERE → ORDER BY”的语法顺序组织语句,直觉上认为代码顺序即执行顺序。但 ...

2026-01-23数字化转型已从企业“可选项”升级为“必答题”,其核心本质是通过数据驱动业务重构、流程优化与模式创新,实现从传统运营向智能 ...

2026-01-23CDA持证人已遍布在世界范围各行各业,包括世界500强企业、顶尖科技独角兽、大型金融机构、国企事业单位、国家行政机关等等,“CDA数据分析师”人才队伍遵守着CDA职业道德准则,发挥着专业技能,已成为支撑科技发展的核心力量。 ...

2026-01-22在数字化时代,企业积累的海量数据如同散落的珍珠,而数据模型就是串联这些珍珠的线——它并非简单的数据集合,而是对现实业务场 ...

2026-01-22在数字化运营场景中,用户每一次点击、浏览、交互都构成了行为轨迹,这些轨迹交织成海量的用户行为路径。但并非所有路径都具备业 ...

2026-01-22在数字化时代,企业数据资产的价值持续攀升,数据安全已从“合规底线”升级为“生存红线”。企业数据安全管理方法论以“战略引领 ...

2026-01-22在SQL数据分析与业务查询中,日期数据是高频处理对象——订单创建时间、用户注册日期、数据统计周期等场景,都需对日期进行格式 ...

2026-01-21在实际业务数据分析中,单一数据表往往无法满足需求——用户信息存储在用户表、消费记录在订单表、商品详情在商品表,想要挖掘“ ...

2026-01-21在数字化转型浪潮中,企业数据已从“辅助资源”升级为“核心资产”,而高效的数据管理则是释放数据价值的前提。企业数据管理方法 ...

2026-01-21在数字化商业环境中,数据已成为企业优化运营、抢占市场、规避风险的核心资产。但商业数据分析绝非“堆砌数据、生成报表”的简单 ...

2026-01-20定量报告的核心价值是传递数据洞察,但密密麻麻的表格、复杂的计算公式、晦涩的数值罗列,往往让读者望而却步,导致核心信息被淹 ...

2026-01-20在CDA(Certified Data Analyst)数据分析师的工作场景中,“精准分类与回归预测”是高频核心需求——比如预测用户是否流失、判 ...

2026-01-20在建筑工程造价工作中,清单汇总分类是核心环节之一,尤其是针对楼梯、楼梯间这类包含多个分项工程(如混凝土浇筑、钢筋制作、扶 ...

2026-01-19数据清洗是数据分析的“前置必修课”,其核心目标是剔除无效信息、修正错误数据,让原始数据具备准确性、一致性与可用性。在实际 ...

2026-01-19在CDA(Certified Data Analyst)数据分析师的日常工作中,常面临“无标签高维数据难以归类、群体规律模糊”的痛点——比如海量 ...

2026-01-19在数据仓库与数据分析体系中,维度表与事实表是构建结构化数据模型的核心组件,二者如同“骨架”与“血肉”,协同支撑起各类业务 ...

2026-01-16在游戏行业“存量竞争”的当下,玩家留存率直接决定游戏的生命周期与商业价值。一款游戏即便拥有出色的画面与玩法,若无法精准识 ...

2026-01-16为配合CDA考试中心的 2025 版 CDA Level III 认证新大纲落地,CDA 网校正式推出新大纲更新后的第一套官方模拟题。该模拟题严格遵 ...

2026-01-16在数据驱动决策的时代,数据分析已成为企业运营、产品优化、业务增长的核心工具。但实际工作中,很多数据分析项目看似流程完整, ...

2026-01-15